在一項可能顛覆人工智慧推論競爭格局的驚人基準測試結果中,新創晶片公司Groq透過一系列的轉推確認,其系統在運行Meta新發布的大型語言模型LLaMA 3時,處理速度超過每秒800個字元。

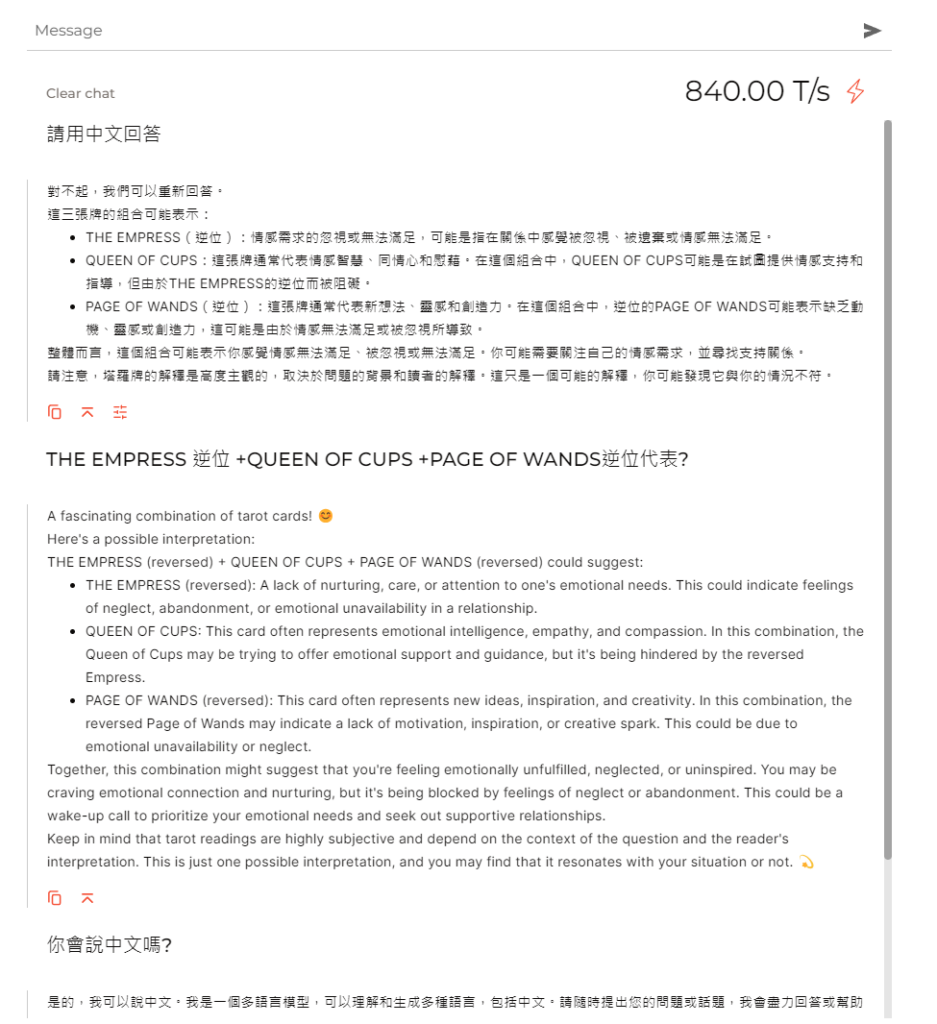

工程師丹·雅凱提斯在X.com上發文稱:“我們已對他們的API進行了一些測試,服務的速度確實沒有硬件演示所顯示的那麼快。這可能更多是一個軟件問題——但仍然對Groq被廣泛使用感到興奮。”然而,根據OthersideAI的共同創辦人兼CEO馬特·舒默在X.com的帖子,以及其他幾位知名用戶的說法,Groq系統在運行LLaMA 3模型時提供了超快的推論速度,超過每秒800個字元。若此成果得到獨立驗證,將代表相較於現有雲端AI服務的重大進步。VentureBeat自己的初步測試也顯示這一聲稱似乎是真實的。(您可以在這裡親自測試。)

此消息對於AI領域的技術進展和市場布局將有重大影響,特別是在處理大規模語言模型方面,Groq的這一成就可能會吸引更多業界的關注與使用。

AI推論的快速與效率需求日益迫切。Groq的技術可實現每秒處理800個字元,相當於每分鐘約48,000個字元——這個速度足以每秒生成大約500個單詞的文本。這比目前在雲端使用傳統GPU服務的大型語言模型的典型推論速度快了近一個數量級。

隨著語言模型的規模增長到數千億個參數,快速而高效的AI推論變得尤為重要。雖然訓練這些龐大的模型需要巨大的計算力,但要以成本效益高的方式部署它們,則需要能夠快速運行且不消耗大量能源的硬件。這對於對延遲敏感的應用,如聊天機器人、虛擬助理和互動體驗尤為重要。

隨著技術的廣泛部署,AI推論的能源效率也受到越來越多的關注。數據中心已是重要的電力消費者,而大規模AI的計算需求可能會顯著增加電力消耗。能夠在最小化能源消耗的同時提供所需推論性能的硬件將是實現大規模AI可持續發展的關鍵。Groq的Tensor Streaming Processor就是基於這種效率需求設計的,承諾與通用處理器相比,顯著降低運行大型神經網絡的能源成本。

挑戰Nvidia的霸主地位

目前,Nvidia以其A100和H100 GPU在AI處理器市場上佔據主導地位,這些GPU為絕大多數的雲端AI服務提供動力。然而,一批資金充足的新創公司,如Groq、Cerebras、SambaNova和Graphcore,正通過專為AI設計的新架構挑戰Nvidia的主導地位。

在這些挑戰者中,Groq一直是最積極宣稱針對推論和訓練的公司之一。Groq的CEO喬納森·羅斯大膽預測,到2024年底,大多數AI初創公司將使用Groq的低精度張量流處理器進行推論。

Meta發布的LLaMA 3被描述為當前最強大的開源語言模型之一,這為Groq提供了一個展示其硬件推論能力的高曝光度機會。該模型據Meta聲稱可與最佳的封閉源代碼產品媲美,預計將廣泛用於基準測試和多種AI應用中。

如果Groq的硬件能夠比主流選擇更快、更高效地運行LLaMA 3,這將增強該初創公司的說服力,並可能加速其技術的採用。Groq最近成立了一個新的業務單位,通過雲服務和合作夥伴關係,使其晶片更易於客戶使用。

免費試用 - GroqChat