你是否曾想過,用一個模型就能同時進行語言翻譯、文章摘要、情緒分析,甚至還能生成詩歌與程式碼?T5 模型讓這一切變得可能。以「文字轉文字」(Text-to-Text)的形式處理所有任務,T5 徹底改變了自然語言處理(NLP)任務的設計方式。Google 在 2024 年推出的 T5Gemma 更進一步,它不僅維持 T5 的通用性,還在效能與效率上達到新高度。

認識 T5 與 T5Gemma 模型的設計理念、核心架構與應用場景。我們會深入解析 Text-to-Text 的概念、Transformer 架構、預訓練與微調流程,並展示如何用 Python 透過 Hugging Face 快速上手。最後,還會介紹 T5Gemma 的特色、訓練細節與實際應用案例,幫助你掌握這套強大的開源語言模型。

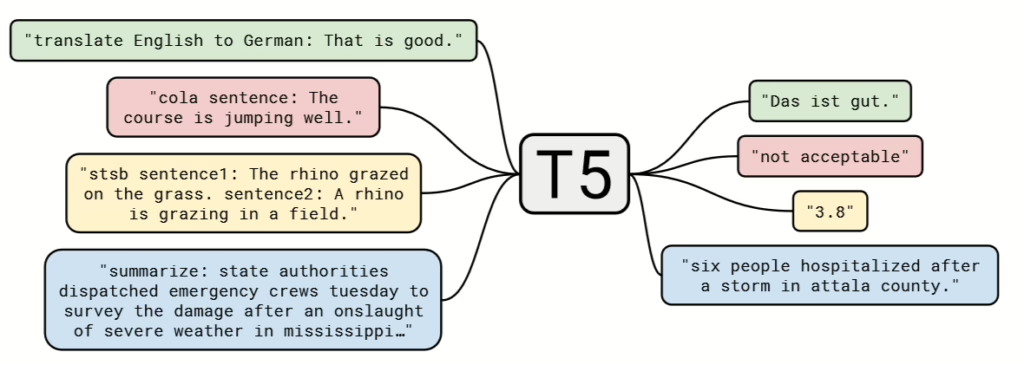

什麼是 Text-to-Text?核心概念

傳統 NLP 任務往往需要為不同問題設計不同的模型架構。舉例來說,情緒分析使用分類器、摘要任務依賴序列到序列模型、而問答系統則需專用的上下文理解架構。這樣的設計不僅複雜,還讓模型重用性大打折扣。

T5 打破了這種限制,提出「Text-to-Text」的統一格式:**任何輸入都是一段文字,任何輸出也都是一段文字。**不論任務是分類、翻譯還是生成,只要以文字表示清楚指令與內容,就能交由同一個模型處理。

✅ 應用實例:

| 任務 | 輸入格式 | 輸出格式 |

|---|---|---|

| 翻譯 | translate English to French: How are you? | Comment ça va ? |

| 摘要 | summarize: The article discusses the rise of AI... | AI is rapidly advancing. |

| 問答 | question: What is AI? context: AI stands for... | Artificial Intelligence |

| 情緒分析 | classify sentiment: I absolutely love this phone! | Positive |

| 主題分類 | classify topic: Stocks surged in Wall Street today... | Finance |

這種統一介面讓開發者可以使用同一模型架構處理所有 NLP 任務,極大簡化了系統開發流程與模型訓練策略。

T5 架構深入解析

🔁 Transformer 架構回顧

T5 基於 Transformer 架構,其核心為「自注意力機制(Self-Attention)」與「編碼器/解碼器(Encoder-Decoder)」設計。簡單來說,編碼器負責理解輸入,解碼器則根據輸入生成對應的輸出。這種設計特別適合序列到序列(Seq2Seq)任務,像是翻譯與摘要。

(👉 延伸閱讀:The Illustrated Transformer)

🔧 T5 模型架構特點

- Encoder-Decoder 結構:與原生 Transformer 類似,但經過 Google 大幅優化,支援更大規模的訓練與推論。

- 任務前綴(Prefix)設計:T5 在輸入文字中加入任務提示,例如:

translate English to French: Hellosummarize: [長文章內容]question: ... context: ...

- 訓練語料 - C4 (Colossal Clean Crawled Corpus):來自網路的大規模乾淨文本資料,讓 T5 能廣泛學習多樣語言風格與任務格式。

- 模型規模與效能選擇:

| 模型名稱 | 參數量 | 適用情境 |

|---|---|---|

| T5-Small | 約 60M | 快速原型、教學用途 |

| T5-Base | 約 220M | 較平衡的訓練與預測速度 |

| T5-Large | 約 770M | 中型任務處理能力強 |

| T5-XL | 約 3B | 高效能應用 |

| T5-XXL | 約 11B | 尖端研究與商業部署 |

這些模型在 Hugging Face 上都可以輕鬆存取,開發者可依照任務資源自由選擇。

✅ 安裝必要套件

pip install transformers torch🧪 Python 程式範例:使用 T5Gemma 執行繁體中文任務(摘要與翻譯)

from transformers import AutoTokenizer, AutoModelForSeq2SeqLM, pipeline

import torch

# 使用 T5Gemma 模型(可依設備選擇小型或大型)

model_name = "google/t5gemma-2b-it" # 或使用 "google/t5gemma-7b-it"、"google/t5gemma-xl-xl-ul2-it"

# 載入模型與 tokenizer

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForSeq2SeqLM.from_pretrained(model_name, torch_dtype=torch.bfloat16).to("cuda" if torch.cuda.is_available() else "cpu")

# 建立 pipeline

generator = pipeline("text2text-generation", model=model, tokenizer=tokenizer, device=0 if torch.cuda.is_available() else -1)

# === 中文摘要任務 ===

chinese_article = (

"台灣的電動機車產業近年蓬勃發展,各大車廠紛紛投入資源研發新款電動車。政府也透過補助政策與基礎建設推動普及化,"

"期望能降低碳排放,達成永續發展目標。"

)

prompt_summary = f"summarize: {chinese_article}"

summary_result = generator(prompt_summary, max_new_tokens=60, do_sample=False)[0]["generated_text"]

print("📄 摘要結果:", summary_result)

# === 中文翻譯任務(中翻英) ===

chinese_text = "translate Chinese to English: 我今天心情很好,因為我完成了所有工作。"

translation_result = generator(chinese_text, max_new_tokens=60, do_sample=False)[0]["generated_text"]

print("🌍 翻譯結果:", translation_result)

輸出範例(實際結果可能略有不同):

📄 摘要結果: 台灣積極發展電動機車產業,政府透過補助與基礎建設推動綠色交通。

🌍 翻譯結果: I feel great today because I finished all my work.