機器人與技術發展

邁向機器人技術的新未來

隨著生成式 AI 和邊緣運算的快速發展,次世代機器人正在迎來技術革新,而 NVIDIA 的 Jetson Orin Nano Super 無疑是這場革命的核心推動力之一。這款嵌入式 AI 平台專為機器人應用而設計,擁有高達 70 TOPS(每秒 70 兆次運算)的強大運算能力,同時能耗僅為 25 瓦。無論是輪式機器人還是人形機器人,它都能提供運行深度學習模型所需的性能,為自主系統注入更多智能。

全面支持生成式 AI 的解決方案

Jetson Orin Nano Super 還支持 NVIDIA 的核心技術生態,包括 CUDA、cuDNN 和 TensorRT,並能輕鬆部署大規模語言模型(LLM),如視覺變換器、語言-視覺模型等。對於開發者而言,這是一個專為技術創新而生的平台,滿足了從生成式 AI 到機器人應用的多樣需求。

經濟實惠的 AI 與開發資源

平價的 AI 超級電腦方案

Jetson Orin Nano Super 的定價僅為 249 美元,比前代產品 Jetson Orin Nano 的 499 美元大幅降低,為開發者帶來極大的經濟效益。如此低廉的價格,配合其強勁的性能,將 AI 技術從高成本的科研實驗室推廣至更廣泛的應用場景。

開發者的夢幻平台

這款設備不僅價格親民,還提供了廣泛的實踐空間。從初學者到專業開發者,都能利用它快速構建生成式 AI 應用,如語言生成聊天機器人、視覺 AI 助理與自主機器人系統,真正實現 AI 技術的平民化。

性能提升與市場價值

性能大幅提升的生成式 AI 平台

Jetson Orin Nano Super 相較前代性能提升 1.7 倍,具備 NVIDIA Ampere 架構 GPU、6 核 Arm Cortex CPU,以及高效的 LPDDR5 記憶體,能以極快的速度處理生成式 AI 模型,無需額外硬體升級便能提供出色的運算性能。

緊湊型 AI 超級電腦的出現

作為一台僅需 249 美元的生成式 AI 超級電腦,Jetson Orin Nano Super 不僅改變了邊緣運算市場的格局,也讓更多中小企業、研究機構及愛好者能以更低門檻加入 AI 技術創新的行列,顯著提升市場價值。

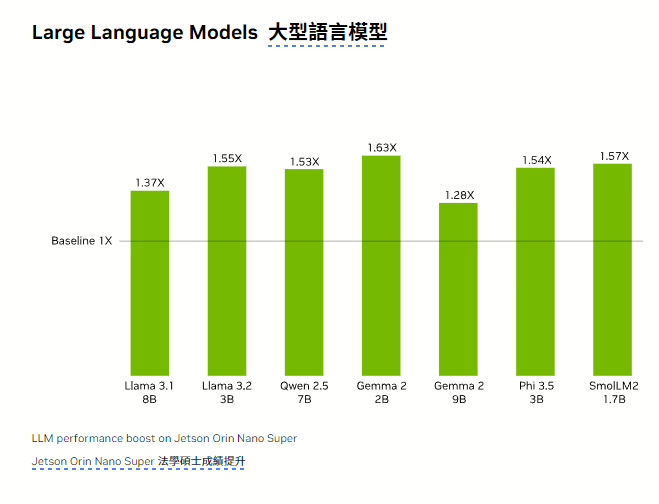

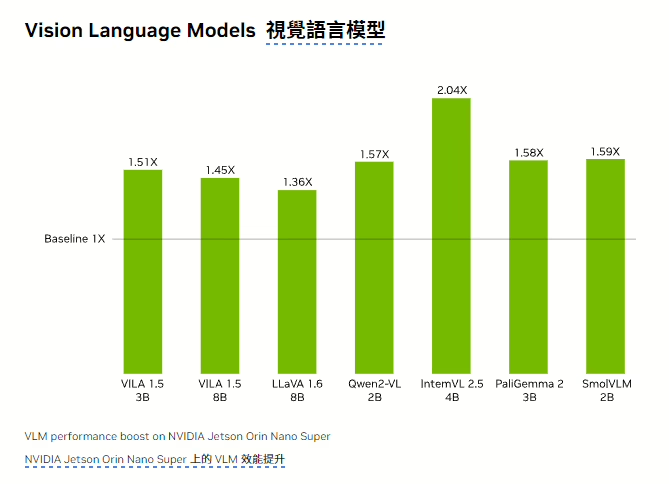

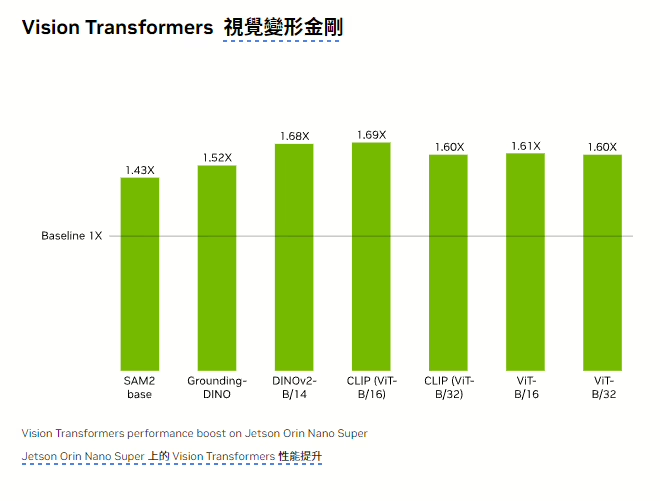

NVIDIA Jetson Orin Nano Super 在各種流行的大型語言模型 (LLM)、視覺語言模型 (VLM) 和視覺 Transformer 上的表現均較其前身顯著提升。

多元應用與生態系統

邊緣 AI 技術的秘密武器

Jetson Orin Nano Super 專為邊緣 AI 場域而生,能支持多路高解析攝影機、傳感器與生成式 AI 模型,適用於智慧城市、自主工業機器人以及更多場景。開發者還能借助 NVIDIA Holoscan、Omniverse Replicator 等工具生成合成資料,縮短模型開發時間。

豐富的全球開發者生態系統

NVIDIA 長期以來建立的開發者生態系統,涵蓋從 NVIDIA Isaac 平台到 Metropolis 的全面支持,為創新應用提供了無限可能。Jetson Orin Nano Super 的推出無疑進一步鞏固了 NVIDIA 在生成式 AI 與邊緣運算領域的領導地位。

Jetson Orin Nano Super 的推出不僅標誌著嵌入式 AI 硬體的進一步平民化,也彰顯了 NVIDIA 推動生成式 AI 與機器人技術發展的承諾。這款性能卓越、價格經濟的 AI 超級電腦,為開發者開啟了通往未來創新的大門,並將持續引領 AI 技術應用的全球新趨勢。

Jetson Orin Nano Super 規格

| 項目 | 規格 |

|---|---|

| AI Performance | 67 INT8 TOPS |

| GPU | NVIDIA Ampere architecture with 1024 CUDA cores and 32 tensor cores |

| CPU | 6-core Arm® Cortex®-A78AE v8.2 64-bit CPU 1.5MB L2 + 4MB L3 |

| Memory | 8GB 128-bit LPDDR5, 102 GB/s |

| Storage | Supports SD card slot and external NVMe |

| Power | 7W–25W |

Q1: DGX H200 跟Jetson Orin Nano Super 哪個比較快?

如果將 NVIDIA DGX H200 與 Jetson Orin Nano(即使是最高規格的 Orin Nano Super 版本)相比,兩者在性能、運算速度與應用定位上有著本質上的巨大差異。

1. 定位與架構層級差異:

- DGX H200 是 NVIDIA 的資料中心級(Data Center級)AI運算平台,它面向的是企業級、高性能計算及深度學習訓練環境。DGX 系列機器通常搭載多顆強力的 GPU(如H100 GPU)與高頻寬、低延遲的網路、以及優化過的軟硬體組合,可提供極高的運算吞吐量。

- Jetson Orin Nano(包含所謂的 Super 版本,如果是指升級過的高階款) 則是針對邊緣運算與嵌入式AI應用所設計的小型平台。該系列強調功耗低、體積小、可在設備端或邊緣側運行AI推論任務,但就算是最高規格的 Jetson Orin 產品(如 Orin AGX)也與 DGX 等級的系統差距甚大,更何況是較入門的 Orin Nano。

2. 性能與硬體規格:

- DGX H200(假設指 NVIDIA DGX H100 系列家族的一員)可搭載多組 NVIDIA H100 GPU,每組 GPU 都具備強大的 Tensor Core 以及極高的 FP16/FP32/INT8 等多種數據精度的運算能力,且擁有強大的記憶體頻寬和 PCIe / NVLink 高速互聯架構。這使得 DGX H200 在大規模深度學習模型訓練、超大語言模型的加速計算、AI超算應用等方面有驚人的吞吐量與加速能力。

- Jetson Orin Nano 則通常擁有單一或雙GPU模組(例如 Orin NX 或 Nano:Omniverse中也許有被稱為Super的特規版本,但整體仍屬於嵌入式等級),記憶體容量與頻寬、計算量級遠低於 DGX 等級的 Data Center GPU,整體算力可能僅有數 TOPS(Tera Operations Per Second)至數十 TOPS 等級,而 DGX H100 系列等級可達至數百 TOPS 乃至 PetaFLOPS 級別的 AI計算能力。

3. 實務應用方面差距:

- DGX H200 適用於企業或研究機構的高階AI訓練、模型開發與加速,不論是大規模 NLP 模型、CV 超大型模型、生成式 AI、分子動力學模擬、科學計算等,都可以達到極高速運算。

- Jetson Orin Nano 適用於邊緣端的推論(Inference)應用,如智慧攝影機、邊緣伺服器、無人機、機器人與工業自動化的AI感知與控制,可在低功耗下執行中小型AI模型的推論。

結論:

如果單純談「誰比較快」,DGX H200 毫無疑問是比 Jetson Orin Nano Super 快許多的。前者是資料中心級的巨大運算平台,後者則是小型、低功耗的邊緣AI系統,兩者定位不同,性能差距巨大,無法直接相提並論。

Q2: 可是Jetson Orin Nano Super 有70 TOPS

即使假設有某個特規版本的 Jetson Orin Nano(您所稱的 "Super")可達到 70 TOPS(INT8 推論性能),與 NVIDIA DGX H200 之類的資料中心級別 AI 伺服器相比,性能差距仍然相當巨大。

1. TOPS 數值比較的意義:

- Jetson Orin Nano 類產品標榜的是在數瓦到十幾瓦的功耗等級下,達到數十 TOPS 的 AI 推論性能,主要目標是邊緣運算、嵌入式系統與小型機器人的 AI 推論任務。

- DGX H100 / H200 類型的產品(NVIDIA DGX 系列)是資料中心級的運算平台,一台 DGX 系統內含多顆 NVIDIA H100 GPU,而單顆 H100 GPU 在 INT8 推論性能可達到數千 TOPS(甚至更高),整台 DGX 系統整合多顆 H100 時,可達數萬甚至更高量級的 TOPS 整體算力。

2. 資料中心級與邊緣級的本質區別:

- DGX H200(或 DGX H100)主要用於深度學習訓練及大規模推論、生成式 AI、科學運算、超大型語言模型(Large Language Model, LLM) 及高階研究等,需要極高的記憶體頻寬、超高速網路互連及超大算力。

- Jetson Orin Nano Super (70 TOPS) 依然屬於低功耗、單板式/嵌入式解決方案,更強調在設備端(如機器人、無人機、邊緣攝影頭、智慧工廠終端)即時進行推論,而非大規模的訓練或海量資料中心級應用。

3. 整體運算規模與性能依舊雲泥之別:

雖然 70 TOPS 對於嵌入式系統來說已屬於相當優秀的性能,但相對於 DGX 級別的平台,它的運算能力仍然只能用「大相逕庭」來形容。DGX 平台可同時應付上百億參數的模型訓練與推論,這是 Orin Nano 等級產品所無法企及的規模。

總結:

就算 Jetson Orin Nano Super 有 70 TOPS,其性能仍無法接近 DGX H200 的級別。DGX H200 屬於雲端資料中心AI加速器,其算力、記憶體頻寬、系統規模與整體計算潛能遠高於邊緣運算平台的 Jetson Orin Nano 系列。簡言之,DGX H200 的速度和性能依然遙遙領先。

Q3: DGX H200 運算能力是多少?

目前並沒有名為「DGX H200」的正式 NVIDIA 產品名稱,可能是將兩個型號混淆了。NVIDIA 的 DGX 系列在最近的世代中主要有兩個與「H」相關的型號:

- NVIDIA DGX H100: 這是以多顆 H100 GPU 所組成的資料中心級 AI 系統。

- NVIDIA DGX GH200: 這是 NVIDIA 在 2023 年公布的超大規模 AI 計算平台,採用 Grace Hopper(GH)超晶片架構。

由於您之前提及 DGX H200,推測您可能指的是其中之一,較有可能是 DGX H100 或 DGX GH200。以下是這兩者的運算能力概略說明:

DGX H100 的運算能力

- 單顆 H100 GPU 性能(最高值,使用 Tensor Core 並啟用稀疏性):

- INT8:約 4,000 TOPS(4 PetaOPS)

- FP16:約 2,000 TFLOPs (2 PFLOPs)

- DGX H100 系統內含 8 顆 H100 GPU:

- INT8 整體性能可達約 32,000 TOPS(即 32 PetaOPS)級別。

- 在 FP16、FP32、FP64 等浮點精度下的性能也同樣有數十 PetaFLOPs 的級距。

這樣的算力遠高於僅 70 TOPS 級別的嵌入式 Jetson 系統。

DGX GH200 的運算能力

NVIDIA DGX GH200 是將 256 顆 Grace Hopper 超晶片整合成一個超大規模共享記憶體 AI 系統,可望達到 ExaFLOPs (百萬 TFLOPs)的級別,以支援超大型深度學習模型訓練與推論。這已經是「超級電腦級」的 AI 平台。

結論:

若您指的是 DGX H100,整套系統(8 顆 H100 GPU)在 INT8 數據型態下可提供約 32,000 TOPS 的性能,遠超過 Jetson Orin Nano Super 的 70 TOPS。若您指的是 DGX GH200,則其整體性能甚至到達 ExaFLOP 級別,更是難以相提並論。

Q4: 這樣一般的CPU例如 R9 或I9 的運算能力為?

一般的高階消費級 CPU(例如 AMD Ryzen 9 或 Intel Core i9)在整數或浮點運算能力(FLOPs)方面,與專業 GPU 或 AI 加速器相較仍然有相當大的差距。雖然 CPU 的主頻、核心數量、指令集優化(如 AVX、AVX2、AVX-512)都會影響其 FLOPs 計算峰值,但以下為一個概略的參考範圍:

以現代高階桌上型 CPU 為例:

- AMD Ryzen 9 系列(如 Ryzen 9 7950X)擁有 16 核心(32 線程),主頻在 4GHz~5GHz 左右,支援 AVX2(但無 AVX-512)。

- 以雙精度 (FP64) 簡單估算:

- AVX2 指令寬度為 256-bit,可同時處理 4 個 double 浮點數(1個AVX2向量指令)。透過 FMA(Fused Multiply-Add)可在一個指令中執行2個浮點運算,因此一個指令周期可達 8 個浮點運算(4個double×2 FLOPs)。

- 若單核心在約 5GHz 時,理想情況下(每週期都能執行 1 個FMA AVX2指令):

- 單核心峰值:5 GHz × 8 FLOPs = 40 GFLOPs (FP64)

- 全16核心理想峰值:約 40 GFLOPs ×16 = 640 GFLOPs (約0.64 TFLOPs, FP64)

若使用單精度 (FP32) 並有更好的指令並行化,有機會再提升一倍左右,但基本上仍在 1~2 TFLOPs 以下的等級。

- 以雙精度 (FP64) 簡單估算:

- Intel Core i9 系列(如 i9-13900K)雖然有更多核心(8 P-core + 16 E-core),但 E-core 不支援高級向量指令集的效率較低;P-core 若支援 AVX-512(部分代次移除或受限於 BIOS 設定)則有機會提高計算密度。如果假設有完整 AVX-512 支援(512-bit寬度)與 FMA 指令,每核心理想 FLOPs 可再增加一倍左右。但實際因程式碼最佳化、指令並行度、記憶體頻寬等因素,實務中很難達到理論峰值。總體而言,高階 i9 CPU 的 FLOPs 等級也可能在百 GFLOPs 至約1 TFLOP 之間的範疇。

與 GPU/AI 加速器的對比:

- 一顆高階的資料中心 GPU(如 NVIDIA H100)輕易達到數 PetaFLOPs(千萬 GFLOPs) 的級別,

- 即使是嵌入式的 Jetson Orin Nano(幾十 TOPS的INT8性能)在特定 AI 推論任務中也遠勝 CPU 的通用 FP64/FP32 性能。

結論:

一般頂級桌上型 CPU(R9 或 I9)在理論最大運算能力上,通常僅能達到數百 GFLOPs 至約 1 TFLOP 上下(視精度與指令集而定),這和 GPU 或專業 AI 加速硬體動輒數十到數千 TFLOPs 的等級有顯著落差。

Q5: Jetson Orin Nano Super 跟一般頂級桌上型 CPU(R9 或 I9) 比較

整體概念比較:

Jetson Orin Nano Super(70 TOPS)與一般頂級桌上型 CPU(如 AMD R9 或 Intel i9)是定位與特化方向完全不同的產品。前者是為 AI 推論(Inference)而優化的嵌入式 GPU/SoC 平台,後者是通用計算(General Purpose)的桌上型中央處理器。儘管 CPU 整體靈活性高、可應付多樣化工作負載,但在特定的 AI 計算(如深度學習推論的矩陣乘法、卷積運算)表現上,Jetson Orin Nano Super 這類 AI 加速器擁有顯著的優勢。

性能比較角度:

- AI 推論性能(TOPS 指標):

- Jetson Orin Nano Super: 約 70 TOPS(INT8)

- 頂級桌上型 CPU(R9、I9): 一般以 GFLOPs 或 TFLOPs 計算浮點性能,CPU 並非以 TOPS 衡量,也無專門的 AI Tensor 核心。即便透過向量化指令(AVX2/AVX-512)達到數百 GFLOPs ~ 1 TFLOP 的理論峰值(FP32或FP64),在 INT8 的 AI 推論作業上,整體仍難以媲美具備專用AI加速器的 GPU/SoC。

- 能效比(Performance per Watt):

- Jetson Orin Nano系列設計重點是低功耗、高 AI 性能比。在幾十瓦以內的功耗下,就可達到 70 TOPS 的 AI 推論性能,能效比極高。

- 桌上型 R9 或 I9 的 TDP(熱設計功耗)通常在 100~200W 範圍內,雖然整體通用計算能力與運行速度快,但在同功耗下的 AI 推論任務能效比落後具備專門加速器的 Jetson。

- 應用場合差異:

- Jetson Orin Nano Super: 適用於邊緣AI推論、智慧攝影機、機器人、無人機,以及需要在現場(Edge)即時處理 AI 任務的場景。

- R9/I9: 適用於一般 PC、工作站,在程式開發、遊戲、影音編碼、虛擬機運行、資料庫應用或需要多樣且不侷限於 AI 的計算工作時更全面。

總結:

若單純針對 AI 推論效能(尤其是 INT8 深度學習推論)進行比較,Jetson Orin Nano Super 會遠遠超過一般頂級桌上型 CPU。它擁有專為 AI 計算優化的架構與核心,使得在 AI 辨識、推論任務中表現出色。然而,CPU 與 GPU/AI SoC 的設計目標不同,CPU 更偏向通用性和靈活性,不以在特定 AI 工作中達成超高TOPS為目標。

Q6: 理論上用Jetson Orin Nano Super 當桌上型電腦是可行的嗎?

簡短回答:

理論上是可行的,但實務上並不理想。

詳細解析:

- 作業系統與軟體支援:

Jetson Orin Nano 系列可運行 NVIDIA 提供的 Linux 系統映像檔(JetPack SDK),該 SDK 基於 Ubuntu,可以安裝常用的 Linux 軟體工具與桌面環境。因此,從軟體角度來看,將其作為「桌上型電腦」運行是可行的。 - 硬體擴充與周邊連接:

Jetson Orin Nano 開發套件通常提供 HDMI/DisplayPort、USB、乙太網路等 I/O 介面,也能接鍵盤、滑鼠、螢幕及外接儲存裝置。基本的桌面使用需求,如上網、文書處理、影像瀏覽、執行某些開發工具,是可以達成的。 - 效能考量:

雖然 Jetson Orin Nano Super 有著良好的 AI 推論能力(70 TOPS),但在一般 CPU 計算、單核心效能、指令執行速度方面仍不及專為桌面用途設計的高階 x86 CPU(如 AMD R9、Intel i9)。- 做一般辦公、上網、影音串流:基本沒問題。

- 進行大量編譯、複雜影像編輯或遊戲:效能可能不足,並且軟體相容性也不如 x86 桌機平台成熟。

- 能效與溫控考量:

Jetson Orin Nano 的優勢在於低功耗、高效能 AI 推論。但身為桌機使用時,由於整體運算資源有限,在多工、記憶體容量與儲存介面速度等方面不如傳統桌上型主機靈活。仍可用散熱模組維持正常運行,但無法期待它提供如桌機等級的資料處理量。 - 市場與設計定位:

Orin Nano 預設是嵌入式或邊緣AI裝置,設計上的重點不是成為桌面主力運算平台。你可以將它當作一個「能跑桌面環境的微型電腦」,類似 Raspberry Pi 或其他 SBC(Single Board Computer)加強版,但它的強項在AI推論,而非通用運算性能。

總結:

從技術角度來看,用 Jetson Orin Nano Super 當桌上型電腦是可行的。它能裝 Linux 桌面、接各種週邊、上網、多媒體播放、開發簡單程式。然而,它不會提供如傳統 x86 高階桌機的整體效能與體驗。若你的目標只是低功耗、可在桌面操作的 AI 加速平台,那麼 Jetson Orin Nano Super 當桌機是有趣且可行的選項,但它並不是傳統意義上「強大」的桌上型主機替代品。

Q7: 如果稱為超級電腦 算錯誤嗎?

如果將每秒 70 兆次運算的設備稱為超級電腦,是否錯誤取決於語境和定義的嚴謹程度。

嚴謹的定義下:

稱它為超級電腦可能不夠精確。現代超級電腦通常指:

- 具有極高的運算能力(目前主流超級電腦在 PetaFLOPS 級別或更高)。

- 專為大規模運算設計,包含多節點、多 GPU 或 CPU 的協同運作架構。

- 用於特定的科學或工程計算,比如氣候模擬、基因運算、大型 AI 模型訓練等。

從這些角度來看,70 TFLOPS 的設備雖然性能優越,但可能更適合歸類為高性能計算設備(High-Performance Computing Device),而非真正的超級電腦。

寬鬆的語境下:

如果是非技術場景,將其稱為「超級電腦」並非完全錯誤,尤其是對於一般用戶或非 HPC 領域的人來說,70 TFLOPS 已經非常強大,遠遠超過日常使用的普通計算機。這樣的說法更多是為了表達其性能卓越,而非嚴格符合超級電腦的標準。

如何避免誤會?

- 如果在專業領域,建議避免稱它為超級電腦,而是使用「高性能計算設備」或明確說明它的性能數據。

- 如果是日常交流,強調它的「高運算能力」即可,例如說「這台設備的運算能力媲美小型超級電腦」。

總之,稱為「超級電腦」並非完全錯誤,但更精確的描述會取決於受眾和場合。

Q8: 那Jetson Orin Nano Super 跟”頂級顯示卡”比?

Jetson Orin Nano Super(70 TOPS):定位在低功耗、邊緣/嵌入式AI推論平台,強調在小體積與有限電力需求下,提供不錯的 AI 運算效能。

頂級顯示卡(例如 NVIDIA GeForce RTX 4090):定位於高階桌面或工作站,提供大幅度更高的運算效能(包含 AI、圖形渲染、遊戲等),但功耗與體積也更高。

1. AI 算力(推論/訓練性能)

- Jetson Orin Nano Super (70 TOPS)

- 這個 70 TOPS (INT8) 主要針對 AI 推論 (Inference) 工作負載而優化。

- 如果要用來做小規模或中型的模型推論,例如影像分類、目標檢測、一些嵌入式場景的深度學習推論,非常合適。

- 但要用它來進行大規模訓練,或是超大型模型(例如數十億參數的 Transformer)推論,就會力不從心。

- 頂級顯示卡(RTX 4090 之類)

- RTX 4090 的 FP16 / Tensor Core 數值運算可達數百 TFLOPs 以上,INT8 推論性能更是可以達到數百甚至上千 TOPS 級別(取決於驅動程式、Tensor Core 使用模式、是否啟用稀疏性等)。

- 除了 AI,亦可提供高效能圖形渲染、遊戲、內容創作者所需的影音編碼、3D 加速等功能。

- 即便不如資料中心級(如 H100)那麼誇張,作為民用「頂級顯示卡」,其在 AI 推論與小規模訓練上的效能依然遠大於 Orin Nano。

2. 功耗與尺寸

- Jetson Orin Nano Super

- 功耗在數瓦至幾十瓦範圍(具體取決於負載與散熱設計),屬於超省電的 SoC/嵌入式平台。

- 適合在邊緣裝置、機器人、無人機、智慧攝影機等空間與功耗受限的環境使用。

- 頂級顯示卡

- 以 RTX 4090 為例,TDP 在 450W 左右,實際滿載功耗甚至更高,還要考慮整機 CPU、主機板、記憶體、電源等加總。

- 體積也較大,需要高階散熱解決方案(3 槽或更多空間),對電源供應器與機箱大小都有更高要求。

3. 記憶體容量與頻寬

- Jetson Orin Nano Super

- 針對嵌入式AI任務,通常配備 8GB ~ 16GB 之類的 LPDDR5 記憶體,頻寬有限。

- 適合跑中小型 AI 模型,如果模型超出記憶體就需要壓縮、量化或切分。

- 頂級顯示卡

- RTX 4090 有 24GB 的 GDDR6X,大幅提高了顯示與計算所需的記憶體頻寬,且頻寬可達到 1TB/s 級別。

- 更容易放下相對大一些的模型或一次同時推論大量資料。

4. 實際應用場合

- Jetson Orin Nano Super

- 適合在邊緣端進行即時影像辨識、智慧監控、機器人視覺等,重視「低功耗、穩定、小體積」以及「足夠的 AI 推論效能」。

- 也可用於開發嵌入式 AI 專案、具備必要的 I/O 與安裝簡易的 SDK(JetPack),在有限空間中完成推論。

- 頂級顯示卡(RTX 4090 等)

- 適合高階遊戲玩家、3D 建模渲染、視覺特效、影片製作、深度學習研究開發人員等,需要同時有強勁的圖形處理能力與相當不錯的 AI 加速性能。

- 若需要在桌面端進行中大型模型的訓練或推論、或需要高階 Ray Tracing 遊戲效果,則頂級 GPU 更適合。

如果你是要在邊緣或嵌入式環境部署 AI,Orin Nano Super 是不錯的選擇;若你需要桌面級、大算力、可支援遊戲或大量運算/渲染等工作,頂級顯示卡才是更合理的選擇。